Pierre Huyghe: UUmwelt, Installation view, Serpentine Gallery, London, (3 October 2018 – 10 February 2019). Copyright Ola Rindal. Courtesy of the artist and Serpentine Galleries

Ruggero Eugeni

I don’t want to exhibit something to someone, but rather the reverse: to exhibit someone to something.

Pierre Huyghe

Uumwelt

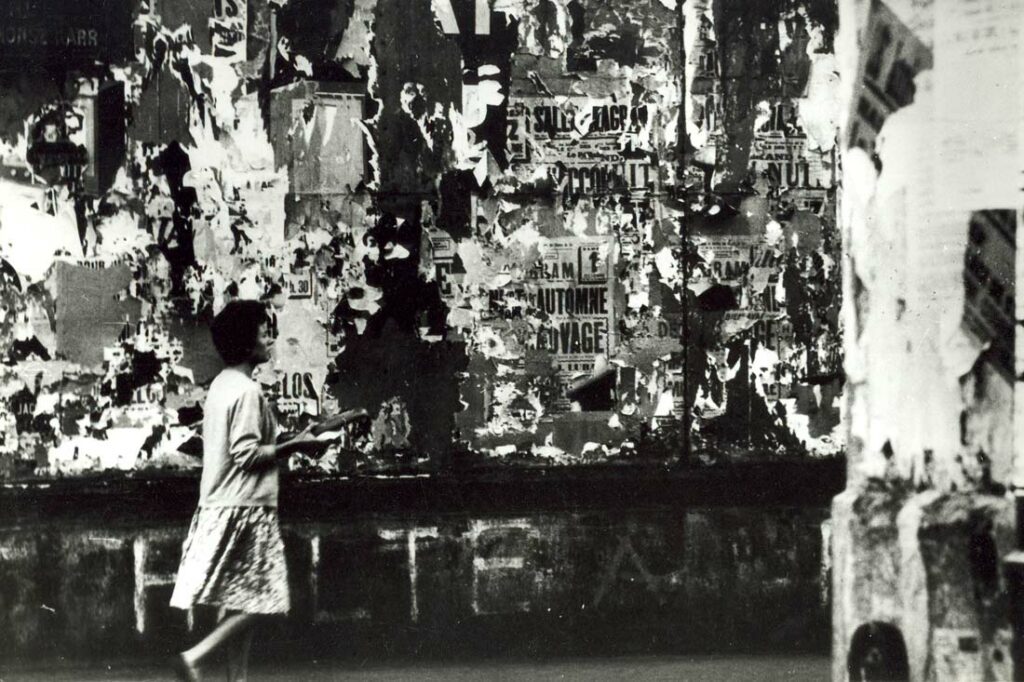

La mostra Uumwelt, di Pierre Huyge ha occupato la Serpentine Gallery di Londra dal 3 ottobre 2018 al 10 febbraio 2019 (1). Il visitatore della mostra si trovava in uno spazio parzialmente oscurato: la luce esterna filtrava e raccontava la mutevolezza del tempo e delle condizioni atmosferiche nell’arco della giornata. Negli spazi della galleria spiccavano cinque grandi schermi LED appoggiati al pavimento. L’ambiente aveva un odore particolare, legato a specifiche condizioni di temperatura e umidità. In occasione della mostra le pareti della galleria, reduci da molteplici tinteggiature, erano state sabbiate e la polvere risultante era stata lasciata sul pavimento e circolava nell’aria. Una colonia di circa 50.000 mosche era stata immessa nella sala centrale della galleria, regolarmente nutrita dagli inservienti con una soluzione zuccherina, e libera di sciamare in tutto lo spazio della mostra; gli insetti completavano il proprio ciclo di vita di circa tre settimane, morivano, si riproducevano dando vita a nuove covate di larve che si dischiudevano. Una colonna sonora discreta e materica, fatta di click, soffi e percussioni accompagnava la visita.

Le immagini che scorrevano sui video erano piuttosto inquietanti: si trattava di incerti ibridi umano-animali, che trasmutavano incessantemente l’uno nell’altro con un effetto di morphing in un flusso costante, arrestato solo improvvisamente e inaspettatamente da pause di qualche decimo di secondo. Questo flusso di immagini e i momenti di improvvisa pausa in ciascuno schermo venivano determinati momento per momento a partire da un set di variabili ambientali: le condizioni di temperatura e umidità dell’aria, il grado di illuminazione, la presenza e il passaggio delle mosche e dei soggetti umani – tutti parametri captati da una rete di sensori e trasmessi al centro di trasmissione delle immagini –.

Nel seguito di questo intervento mi propongo di comprendere meglio il senso e la portata della mostra – installazione di Huyge fin qui sommariamente descritta. Lo farò in due tempi. Anzitutto, confronterò l’opera di Huygecon alcune espressioni del visuale e dell’arte contemporanea, in modo da far risaltare la specificità del lavoro dell’artista francese rispetto a lavori e operazioni “adiacenti”. In un secondo momento amplierò lo sguardo al rapporto tra il visuale e il visibile all’interno della presente condizione postmediale: questa mossa mi permetterà di valutare a pieno la portata estetica e politica dell’opera di Huyge.

1 Generative Adversarial Networks

Torniamo alle inquietanti immagini che scorrevano sui video di Uumwelt. Queste erano state ottenute con un metodo particolare: Huyghe si è rivolto al laboratorio di Yukiyasu Kamitani, un neuroscienziato di Kyoto, che sta sperimentando la possibilità di registrare e visualizzare attraverso dispositivi di risonanza magnetica e successive rielaborazioni mediante intelligenze artificiali, le immagini mentali che un soggetto vede o pensa.

Il dispositivo messo a punto da Kamitani prevede due fasi di lavoro (2). In una prima fase viene mostrata a un soggetto una certa immagine, e nel contempo viene eseguita una risonanza magnetica funzionale delle aree visive della corteccia cerebrale; i risultati della risonanza vengono tradotti (decodificati, secondo l’espressione dello scienziato) nei pattern dinamici di un Deep Neural Network (DNN),una forma di intelligenza artificiale esemplata sulla struttura a livelli gerarchici della corteccia visiva: in tal modo l’immagine “naturale” di partenza viene tradotta in un pattern di dati nella forma di un DNN. La seconda fase del dispositivo di Kamitani mira alla ricostruzione dell’immagine “come viene visualizzata dal cervello” (lo scienziato parla di “deep image reconstruction”). A questo fine vengono messi a confronto e in interazione due DNN: il primo (chiamato anche deep generator network, o DGN) modifica pixel per pixel l’immagine di partenza, mentre il secondo valuta la rispondenza tra l’immagine via via ottenuta e il modello costituito dalla configurazione originaria, minimizzando gradualmente il margine di errore fino ad arrivare a un grado soddisfacente di corrispondenza. L’immagine che ne risulta è considerata quella “vista” o “pensata” dalle aree visuali del cervello del soggetto.

Questa seconda parte del procedimento di Kamitani utilizza la variante di una tecnica introdotta nel 2014 dal ricercatore canadese Ian Goodfellow, che viene oggi utilizzata molto frequentemente sia per addestrare una AI al riconoscimento di immagini, sia per produrre immagini “originali”: si tratta del Generative Adversarial Network (GAN) (3). In sostanza (riducendo al minimo gli aspetti tecnici) un GAN funziona mettendo in competizione due DNN: il primo è chiamato Generatore, il secondo Discriminatore. Il Generatore produce una serie potenzialmente infinita di immagini a partire da un deposito più o meno casuale di forme, mentre il Discriminatore deve riconoscere se qualcuna delle forme prodotte corrisponde a qualcuna delle immagini facenti parte di un repertorio prefissato (training set): il Generatore modifica le sue proposte in base alle indicazioni del Discriminatore; a sua volta il Discriminatore impara a riconoscere sempre meglio le immagini facenti parte del training set correggendo i propri errori; di conseguenza l’interazione tra i due DNN produrrà immagini sempre più vicine a quelle che compongono il repertorio. Per esempio, se il training set è composto da immagini di gatti, il Generatore imparerà sempre meglio a proporre immagini di pseudo-gatti che “ingannino” il Discriminatore, mentre il Discriminatore imparerà sempre meglio a riconoscere immagini di gatti retrodeterminando il Generatore. Come è stato detto efficacemente, un simile processo “mimics the back-and-forth between a picture forger and an art detective who repeatedly try to outwit one another.” (4)

Si comprende facilmente il possibile duplice utilizzo dei GAN: nati per raffinare al massimo i processi di riconoscimento di immagini da parte di intelligenze artificiali (e tutt’ora ampiamente utilizzati in questo senso, per esempio per implementare il riconoscimento facciale), i GAN possono anche essere usati per produrre immagini “di sintesi”. Gli utilizzi di questo tipo si sono sviluppati in vari ambiti del visuale. Per esempio il software Style GAN può generare un milione di volti sintetici al giorno, richiesti tra l’altro dalle app di incontri sentimentali o sessuali per implementare falsi profili nel caso ci fosse bisogno di bilanciare la percentuale di presenze maschili o femminili (5); oppure utilizzati per aprire falsi profili social di attivisti che rilancino e quindi amplifichino la portata di alcuni messaggi politici (6). Un altro campo di applicazione “creativa” dei GAN sono i cosiddetti “deep fakes”, video in cui i volti e le espressioni facciali di alcuni personaggi noti vengono perfettamente sovrapposti a quelli di un attore: nati nell’ambito del porno (per applicare i volti di alcune celebrities ai corpi di pornoattrici, con particolare predilezione per le protagoniste della serie Il Trono di spade), i deep fakes hanno trovato un ambito di applicazione promettente nel campo della comunicazione politica (7). Una variante professionale dei deep fakes si ritrova nei visual effects cinematografici: per esempio le tecniche di ringiovanimento del volto di Robert de Niro in The Irishman (Martin Scorsese, Usa, 2019) messe a punto dalla Industrial Light and Magic prevedevano che il volto dell’anziano attore venisse sostituito da quello dello stesso De Niro da giovane, selezionato da un GAN a partire da un training set costituito dai primi piani di tutte le interpretazioni dell’attore svolte anni addietro (8). Sullo stesso principio la Disney ha recentemente brevettato un Face re-aging network (Fran): gli spettatori hanno potuto vederne un esempio nei primi minuti di Indiana Jones e il quadrante del destino (Indiana Jones and the Dial of Destiny, James Mangold, USA 2023), in cui Harrison Ford passa dai suoi attuali 81 anni ai 35 del flashback che apre il film (9). Infine, alcuni utilizzi amatoriali legati ai GAN e ai deep fakes sono alla portata di tutti grazie ad app per smartphone come la popolare Xpression. E gli esempi potrebbero continuare (10).

Anche il mondo dell’arte è stato attento a cogliere le opportunità offerte dai GAN. Nell’ottobre 2018 la casa di aste Christie di New York batteva il Portrait of Edmond de Belamy, un ritratto generato da un algoritmo, per la somma di $432,500. L’”autore” dell’opera è il collettivo francese Obvious, che ha addestrato un algoritmo GAN al riconoscimento e alla produzione di immagini utilizzando un ampio data base di ritratti dal Trecento al Novecento (11). Qualche mese dopo, dal 13 febbraio al 5 marzo 2019 la HG Contemporary Gallery di Chelsea ha ospitato la mostra “Faceless Portraits Transcending Time”, con grandi immagini di volti deformati un po’ nello stile di Francis Bacon nate da “the collaboration between an artificial intelligence named AICAN and its creator, Dr. Ahmed Elgammal”. Elgammal, un professore di computer science alla Rutger University, utiliza una metodologia che pur partendo dalla tecnica dei GAN la modifica leggermente: in questo caso il discerner viene programmato non per individuare similarità, ma al contrario per introdurre differenze, minime alternazioni ripetute che produrrebbero un progresso nell’arte. Elgammal parla a questo proposito di Creative Antagonist network (CAN, da cui appunto la sigla AICAN). L’operazione ha anche uno specifico versante economico: Elgammal sta lanciando l’azienda Arttrendex, che offre servizi di AI per il mercato dell’arte (per esempio per l’autentificazione di quadri, o per suggerire a un collezionista opere affini ai suoi gusti, o anche per intravedere quali sono le tendenze emergenti del mondo dell’arte) (12).

Dunque, il lavoro che Huyghe compie sulla base dei risultati di laboratorio di Kamitaninon non è isolato rispetto al mondo dell’arte, né rispetto al più ampio campo del visuale contemporaneo; tuttavia, esso si distacca chiaramente dalle produzioni che abbiamo esaminato, per almeno tre ragioni. In primo luogo, Huyghe, facendo riferimento al lavoro di Kamitani, non utilizza un normale data set di immagini “naturali” (men che meno di opere d’arte), quanto piuttosto le traduzioni di quelle immagini in pattern neurali a loro volta tradotti nei pattern algoritmici di un DNN. In altri termini l’artista non vuole mostrarci una immagine prodotta da una macchina, ma il modo in cui la macchina algoritmica riproduce e visualizza un pensiero visivo. In secondo luogo, ciò che interessa a Huyghe in questo dispositivo di visualizzazione non è il risultato del lavoro dei due DNN del GAN, quanto piuttosto la processualità del loro dialogo: l’artista sceglie di non mostrare le immagini di partenza, e neppure quelle di arrivo, quanto piuttosto i processi di incessante adeguamento che l’intelligenza artificiale produce nel tentativo asintotico di replicare perfettamente l’immagine mentale. In terzo luogo, il flusso di immagini che deriva da quanto sopra viene “ambientalizzato”, ovvero messo in relazione e fatto interagire con altri flussi (di persone, aria, luce, temperatura, umidità, polvere, mosche, etc.) che attraversano e costituiscono il microsistema ecologico dell’ambiente – non ambiente costruito da Huyghe – l’Uumwelt che dà il nome alla mostra –. Per capire l’importanza estetica ma anche politica di queste mosse di Huyghe, occorre ampliare il nostro orizzonte alle logiche di visualizzazione delle immagini nella presente condizione tecnologica e culturale.

2 Una nuova economia politica della luce

I GAN esibiscono in maniera evidente un particolare tipo di relazione tra le immagini e i dati: relazione che si è instaurata con l’avvento delle tecnologie digitali, e che ha profondamente trasformato una serie complessa di precedenti equilibri. Facciamo dunque rapidamente un passo indietro per comprendere in che cosa è consistita questa trasformazione e in cosa consista la relazione attuale tra i dati e il visuale.

La nascita dei media moderni e del loro sistema di immagini è del tutto dipendente da una serie di nuove modalità di gestione della luce: queste, variamente preparate nei secoli precedenti, si manifestano in forme specifiche alla fine dell’Ottocento, con l’avvento della elettricità. Per un verso la luce naturale nelle sue propagazioni (diffusione atmosferica, rifrazione, assorbimento e riflessione) viene incanalata e controllata fino al totale annullamento e alla costituzione di forme di tenebra artificiale (come avviene negli studi fotografici, o nel modello teatrale wagneriano). Per altro verso la luce elettrica (subentrando alla luce a gas) illumina meglio tanto i territori notturni soprattutto urbani, quanto gli interni delle case e dei locali pubblici, e si presta a forme di disciplina, manipolazione e canalizzazione (13).Questa nuova gestione spaziale e temporale dei flussi luminosi non è isolata rispetto a una serie complessa di fenomeni sociali; in particolare, essa è profondamente connessa alla regolazione di altre serie di flussi: di soggetti, di merci, ma anche di conoscenze e ovviamente di denaro e di potere. I flussi luminosi divengono insomma parte di una economia politica della luce deputata alla creazione di nuove forme di valore.

Uno degli snodi fondamentali della produzione del valore propri della economia politica della luce è la costruzione di immagini. I flussi elettrico-luminosi rivestono un ruolo chiave nei passaggi chiave della logistica delle immagini e soprattutto delle immagini in movimento: produzione, riproduzione, stoccaggio, distribuzione e approvvigionamento, esibizione. In altri termini, l’economia della luce possiede un ruolo di guida e di controllo rispetto alla economia delle immagini. Infine, queste due economie strettamente collegate entrano in contatto con una terza economia, quella dei dati: si pensi per esempio agli archivi di foto segnaletiche, o alla “logistica della percezione” delle riprese aree in guerra (14); tuttavia l’economia dei dati rimane strettamente dipendente da quella delle immagini, dal momento che le informazioni vengono direttamente estratte dalle immagini.

In sintesi, i media moderni si basano su un ruolo guida della economia politica della luce sull’economia di produzione e consumo delle immagini in movimento, e quindi su una economia dei dati basati su informazioni visive. La conseguenza di questo business model è una coincidenza del visuale con il visibile: quanto pertiene all’immagine deriva dalla luce ed è destinato a tornare alla luce.

La convergenza delle tecnologie visuali sulla piattaforma di trattamento dei dati digitali, a partire dagli anni ottanta del novecento, modifica questo equilibrio. I sensori trasformano i flussi fotoelettrici in dati digitali; questi possono essere variamente manipolati; ibridati con dati generati dalle macchine (algoritmi di computer graphics e di machine vision (15)); soggetti a meta datazione mediante riconoscimento; incrociati e rielaborati come avviene attraverso i GAN. Questi processi riguardano quantità di dati sempre maggiori e prodotti in tempo reale, processati in forma automatica da algoritmi di Intelligenza artificiale (torniamo ancora ai GAN). Infine, una serie di algoritmi presiede alla data visualization che può essere statica o dinamica, completamente predeterminata o interattiva. È evidente la trasformazione che si è prodotta: l’economia dei dati si è resa in buona parte autonoma rispetto all’economia delle immagini e quindi rispetto a quella della luce: la conseguenza è una divaricazione tra il visuale e il visibile (16), tale per cui le immagini sussistono in larga parte in una situazione che è stata di recente definita di in visualità (17), ossia in forma di dati che sono soggetti a vari tipi di trattamenti e che sono alla fine visualizzati solo in forme parziali e temporanee.

Un simile sfondo, per quanto tracciato sommariamente, permette di comprendere il senso e la portata dell’operazione affrontata da Huyghe in Uumwelt. Ripercorriamo i tre gesti che abbiamo visto emergere alla fine del precedente paragrafo.

Anzitutto, nel riprendere il tentativo di Kamitani di visualizzare mediante l’utilizzo di DNN le immagini mentali dei soggetti, Huyghe manifesta il suo intento di fondo: portare alla luce le immagini, o per meglio dire restituire il visuale alla luce. Questo “(ri)portare alla luce” si manifesta peraltro in varie altre scelte: per esempio quella di sabbiare i muri riportando a visibilità strati precedenti delle pareti della galleria; o quella di lavorare sulle aperture luminose della galleria disciplinando gli accessi della luce naturale agli ambienti.

In secondo luogo, Huyghe è ben consapevole che il dispositivo messo a punto da Kamitani non visualizza direttamente (“fotograficamente”) una immagine mentale, ma una immagine frutto di una negoziazione processuale algoritmica (il ruolo dei GAN) che cerca di riprodurre asintoticamente l’immagine mentale: di qui la scelta di portare alla luce proprio la processualità inesausta del lavoro dei GAN – una processualità che è normalmente destinata a restare invisibile in quanto ciò che gli algoritmi ci mostrano sono solo i risultati degli innumerevoli tentativi di adeguamento tra i due DNN –.Infine, il flusso di immagini così portato alla luce viene innestato in un ambiente vivente, e fatto interagire come abbiamo visto con una serie di altri flussi (di soggetti, animali, condizioni atmosferiche). Quest’ultima mossa (cui le due precedenti evidentemente tendono) mi sembra decisiva: Huyghe per un verso esprime in tal modo la natura “economico-politica” e mediale di ogni ambiente di vita, costituito da un’infrastruttura di flussi reciprocamente regolati e regolabili (18); e per altro aspetto afferma una contro-economia dei dati, rendendo nuovamente visibile il visuale – sottraendo cioè i flussi di bytes alla loro invisibilità e a loro isolamento –. Nel costruire il suo ambiente-non ambiente, Huyge effettua insomma una critica all’economia politica dei dati e inventa una nuova economia politica della luce.

N.R. Il testo è una rielaborazione dell’intervento presentato al convegno “Postutto” l’ 11 ottobre 2019

- Vari materiali relativi alla mostra sono reperibili presso il sito della galleria: https://www.serpentinegalleries.org/exhibitions-events/pierre-huyghe-uumwelt. Tra i numerosi commenti alla mostra vedi R. Eugeni, Capitale algoritmico. Cinque dispositivi postmediali (più uno), ed. Scholè, Brescia 2021, in part. 175-221; V. Catricalà, R. Eugeni, Dopo l’immagine. La sfida algoritmica alla rappresentazione visuale, in K. Purgar e L. Vargiu (a cura di), Studiare le immagini. Teorie, concetti, metodi, ed. Carocci, Roma 2023, pp. 245-265, in part. pp. 261-265.

- Per una illustrazione completa del metodo e dei risultati si vedano G. Shen, T. Horikawa, K. Majima, Y. Kamitani, Deep image reconstruction from human brain activity, in “PLoS Comput Biol”, 15 (1), 2019, e 1006633, doi 10.1371/journal.pcbi.1006633; G. Shen, K. Dwivedi, K. Majima, T. Horikawa, Y. Kamitani, End-to-End Deep Image Reconstruction From Human Brain Activity, “Front. Comput. Neurosci.”, 13:21, 2019, doi: 10.3389/fncom.2019.00021. I video originali degli esperimenti Kamitani si possono vedere all’indirizzo https://youtu.be/jsp1KaM-avU

- I. J. Goodfellow, J. Pouget-Abadie, M. Mirza, B. Xu, D. Warde-Farley, S. Ozair, A. Courville, Y. Bengio, Generative Adversarial Networks, Submitted on 10 Jun 2014, arXiv:1406.2661 (stat.ML); su modifiche e variant dei GAN si veda la survey Y. Hong, U. Hwang, J. Yoo, S. Yoon, How Generative Adversarial Networks and Their Variants Work: An Overview, “ACM Computing Surveys (CSUR)”, 52/ 1, 2019, No. 10 DOI: 10.1145/3301282, arXiv:1711.05914 (cs.LG). Due volume introduttivi sono J. Langr, V. Bok, GANs in Action: Deep learning with Generative Adversarial Networks, Shelter Island (N.Y.), Manning Publications, 2019; S. Kaddoura, A Primer on Generative Adversarial Networks, Cham, Springer, 2023.

- K. Hao, Inside the world of AI that forges beautiful art and terrifying deepfakes, “MIT Technology Review”, Dec 1, 2018, https://www.technologyreview.com/s/612501/inside-the-world-of-ai-that-forges-beautiful-art-and-terrifying-deepfakes/

- D. Harwell, Dating apps need women. Advertisers need diversity. AI companies offer a solution: Fake people, “The Washington Post”, Jan. 7, 2020, https://www.washingtonpost.com/technology/2020/01/07/dating-apps-need-women-advertisers-need-diversity-ai-companies-offer-solution-fake-people/

- S. Woolley, The Reality Game. How the Next Wave of Technology Will Break the Truth and What We Can Do About It, London, Public Affairs, 2020; M. Filipowicz (ed.), Deep Fakes: Algorithms and Society, Routledge, London – New York 2022.

- Cfr. per esempio W. Knight, Fake America Great Again, “MIT Technology Review”, Aug 17, 2018, https://www.technologyreview.com/s/611810/fake-america-great-again/ e Woolley, The Reality Game, cit.

- S. Li, How Hollywood Became Obsessed With De-aging Its Stars,”The Atlantic”, December 6, 2019, https://www.theatlantic.com/entertainment/archive/2019/12/irishman-gemini-man-and-rise-de-aging/603130/ ; B. Desowitz, ‘The Irishman’: How Industrial Light & Magic’s Innovative De-Aging VFX Rescued Martin Scorsese’s Mob Epic, “Indie Wire”, Dec 6, 2019, https://www.indiewire.com/2019/12/the-irishman-ilm-vfx-de-aging-1202194908/

- (9) G. Zoss et al., Production-Ready Face Re-Aging for Visual Effects, in «ACM Transactions on Graphic», 41, n. 6, Article 237, 2022.

- J. Brownlee, 18 Impressive Applications of Generative Adversarial Networks (GANs), “Machine Learning Mastery”, June 14, 2019, https://machinelearningmastery.com/impressive-applications-of-generative-adversarial-networks/

- I. Bogost, The AI-Art Gold Rush Is Here, in “The Atlantic”, Mar 6, 2019, https://www.theatlantic.com/technology/archive/2019/03/ai-created-art-invades-chelsea-gallery-scene/584134/?utm_campaign=the_download.unpaid.engagement&utm_source=hs_email&utm_medium=email&utm_content=70561544&_hsenc=p2ANqtz-90UOXPm1CWUhuAhUvXbCyX_wiPLZ-rr9eTM6dWslcQ5N6UUX109unHr6fARBq1PeNYuG67FbbJmbKhPpT6K4BNlYXr10npytxlLwBFW3ABlmBkg0Q&_hsmi=70561544 . Il collettivo ha prodotto una intera serie di ritratti della famiglia Belamy, cognome che rappresenta un esplicito riferimento all’inventore dei GAN, I. J. Goodfellow: s.a., Is artificial intelligence set to become art’s next medium?, Christie’s, 12 December 2018, https://www.christies.com/features/A-collaboration-between-two-artists-one-human-one-a-machine-9332-1.aspx.

- In effetti le applicazioni dei GAN all’arte vanno oltre queste manifestazioni più commerciali grazie ad artisti quali Mario Klingemann, Anna Ridler, Georgia Ward Dyer e molti altri. Sul fenomeno si vedano H.Steyerl, Duty Free Art. Art in the Age of planetary Civil War, London – New York, Verso, 2017; A. I. Miller, The Artist in the Machine. The Worlds of A.I. Powered Creativity, Cambridge (MA) – London, The MIT Press, 2019; L. Manovich, A.I. Aesthetics, Moscow, Straelka Press, 2019 (L’esteticadell’intelligenzaartificiale. Modelli digitali e analitica culturale, a cura di V. Catricalà, Luca Sossella Editore, Roma 2020); A. Barale (a cura di), Arte e intelligenza artificiale. Be my GAN, Jaka Book, Milano 2020; J. Zylinska, AI Art. Machine Visions and Warped Dreams, London, Open Humanities Press, 2020; R. Diodato, Immagini chiasmatiche, in “Aut-Aut”, n. 396 (12), 2022, pp. 58-73; A. Somaini, Algorithmic Images: Artificial Intelligence and Visual Culture, in “Grey Room”, 93, 2023, pp. 74-115. Si veda anche (più spostato sul settore mediale) P. Pisters, R. Eugeni (eds.), #Intelligence, Special Section of Necsus, “European Journal of Media Studies”, Spring 2020, https://necsus-ejms.org/portfolio/spring-2020_intelligence/#toggle-id-2-closed .

- Rimando a N. M. Elcott, Artificial Darkness. An Obscure History of Modern Art and Media, Chicago – London, University of Chicago Press, 2016, anche per la corposa bibliografia in merito a questi aspetti.

- S. F. Anderson, Technologies of Vision, The War Between Data and Images, Cambridge (Mass.) – London, The MIT Press, 2017; P. Virilio, Guerra e cinema. Logistica della percezione (1984), ed. Lindau, Torino 2018.

- Simone Arcagni, L’occhio della macchina, ed. Einaudi, Torino 2018.

- W. Hui Kyong Chun, Programmed Visions: Software and Memory, Cambridge (Mass.) – London, The MIT Press, 2011; S. Cubitt, The Practice of Light: A Genealogy of Visual Technologies from Prints to Pixels, Cambridge (Mass.) – London, The MIT Press, 2014; K. Purgar, Pictorial Appearing. Image Theory After Representation, Bielefeld, Transcript Verlag 2019

- J. Parikka, Operational Images. From the Visual to the Invisual, Minneapolis – London, University of Minnesota Press,2023.

- J. Durham Peters, The Marvelous Clouds. Toward a Philosophy of Elemental Media, Chicago – London, The University of Chicago Press, 2015.